随着人工智能的高速发展,我们的生活也发生着翻天覆地的变化。物联网不断发展,被应用到家具、汽车、电子设备等方方面面,同样也被运用到医学领域。

心脏起搏器是一种植入于体内的电子治疗仪器,通过脉冲发生器发放由电池提供能量的电脉冲,通过导线电极的传导,刺激电极所接触的心肌,使心脏激动和收缩,从而达到治疗由于某些心律失常所致的心脏功能障碍的目的。

随着科技发展,一种远程监护管理的先进起搏器也被逐渐运用,,能为病人心脏内植入的起搏器提供24小时监测和记录,一旦有严重异常,系统会第一时间立即通过短信和电子邮件向医生报警。

但是这种技术除了可以救命,还可以随时要你的命。这些设备可能会被黑客远程入侵,以增加心脏活动量或缩短电池寿命,进而可能危及病人生命。

阿里巴巴利用AI攻克心血管识别技术,提取完整冠脉树不超过20秒,相比传统方法效率超高近百倍。

“天泽”脑血管病诊疗辅助决策系统也运用AI技术,大大提高了诊断效率。自动驾驶的Waymo无人车,连接电器自动工作的智能管家,AI减少了人工消耗本是好事。

但随着技术的普及,门槛变低问题也随之出现。

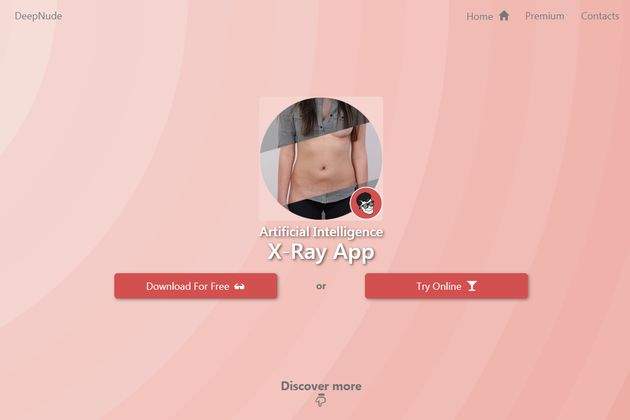

2019年6月美国科技媒体Motherboard报道,一名程序员开发出一款名叫DeepNude的应用,只要给DeepNude一张女性照片,借助神经网络技术,App可以自动“脱掉”女性身上的衣服,显示出裸体。

而且DeepNude只能处理女性照片,如果原图裸露的皮肤越多,处理效果越好;而上传男性照片,最后得出的照片还是替换成女性下体。

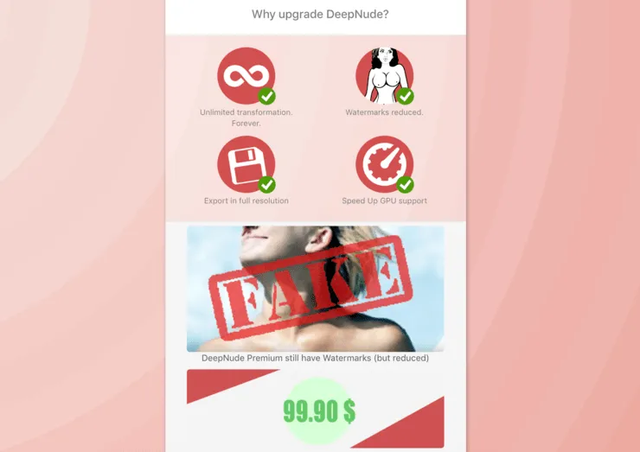

使用免费版获得的图片会出现较大水印,付费版虽然没有免费版出现的水印,但会在图片左上角加上“FAKE”(虚假)的印章式标注。

有媒体测试了Taylor Swift等女星的照片,DeepNude都成功通过AI算法用裸露的器官和皮肤替换掉了人物身上的衣物。DeepNude操作起来比Deepfakes简单太多,因此该软件在发布后几小时内,便因访问请求过大迅速宕机。

Motherboard接着又用几十张照片测试,发现如果输入《体育画报泳装特辑》(Sports Illustrated Swimsuit)的照片,得到的裸体照片最为逼真。

但这一技术还有缺点,多数照片(尤其是低分辨率照片)经过DeepNude处理后,得出的图像会有人工痕迹;而输入卡通人物照片,得出的图像是完全扭曲的。

这些伪造的图片细节上远不如精心PS的效果,但是从某种程度上来说,DeepNude却相当于DeepFakes技术的进化版。

因为它的操作更简单,处理速度更快,用户只需点击一下就能在30秒内获得一张“真实”色情图片。如果它被有心人利用,可能引发更多的恶劣后果。

果然,DeepNude一经曝光后网上便开始流传大量女星裸体的虚假照片,该软件也迅速遭到全球舆论的抨击。

这意味着,如果你想看某个女性的裸照,只需打开脱衣APP,对着她偷偷拍下一张照片,系统就会借助神经网络技术,将该女性的衣服“脱”下来,露出裸体。

DeepNude的创建者“阿尔贝托”(Alberto)表示,该软件基于加州大学伯克利分校研究者开发的开源算法pix2pix创建,并使用1万张女性裸图加以训练。

这一算法与之前的人工智能换脸技术deepfake算法相似,也和无人车技术所使用的算法相似。

“阿尔贝托”说,该软件目前之所以只能用于女性照片,是因为女性裸体图像更容易在网上找到,但他希望能创建一个男性版本的软件。

他还表示,他继续这一实验是出于“有意思”和好奇心。“更重要的是,这项技术能为其带来巨额的收益。

面对这些质疑,DeepNude的开发者Alberto却认为,技术无罪。“我认为用DeepNude做的,用PS同样可以做到,”他说,“并且DeepNude不会自己散播图像,只有创建了这些图像的用户才会用来做坏事。”Alberto还表示,“技术已经发展到这一步了,如果我不这样做,别人也会在一年内做出来。”

不过还好最后DeepNude在舆论批评声中下线了。

虽然DeepNude下线停止运营,但其源代码仍可在各种torrent网站和开放源代码存储库中找到。

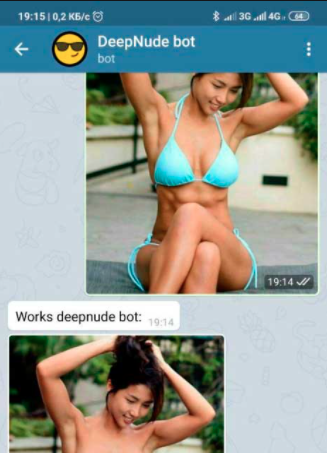

近日,据美国阿姆斯特丹的网络安全公司Sensity调查发现,这款色情的软件再次出现在了即时消息应用程序——Telegram(电报)中。

截止目前,该软件在TeleGram平台已经公开发布了约104,852名女性色情图片,这一数据还不包括私下分享传播的图片。

而且这服务也不是完全免费的,盈利模式和DeepNude一样。

未付费用户获得的裸照后会打上水印标签或者只有局部裸露,用户支付1.28美元才可以获得无水印图片。

更重要的是,这些图片70%全部来自社交网络中的真实女性,甚至包括未成年人。

也就是说,日常在Facebook、微博等社交媒体中分享的自拍照,很可能会被人用来生成“果照”。

他们调查发现,截至7月底,Telegram(电报)平台七个主要频道均在使用DeepNude软件。

从TeleGram平台的公开数据来看,许多照片中的女性都是普通上班族、大学生,而且这些照片都是来自TikTok、Instagram、Facebook等平台的自拍照。

由于源代码用的可能是DeepNude的源代码,这款深度造假软件同样只针对女性。

如果上传一张男性或者其他任何无生命照片,系统也会自动被替换成女生的身体,并识别成相应的器官。

Sensity首席科学家乔治·帕特里尼(Giorgio Patrini)介绍称,目前已经超过680,000名女性在未知情的情况下被伪造成了色情图片,并上传到了公共媒体平台。目前,Sensity公司的相关调查数据已经对外披露,相关执法部门也对此展开了调查。

而至此,为何允许该色情软件出现在社交平台中,Telegram一直未给出公开答复。

不可否认的一点是,与此前AI换脸技术不同,此项技术开发的目的纯粹是为了通过色情牟利。

这项技术将伤害全球女性,加剧人类的性报复心理。

波士顿大学法学教授 Danielle Citron 也表示,“这类软件已经成为了恶意攻击女性强有力的武器。"

试想,如果有一天,网络上突然流传着你的裸体,无论这张裸体是真是假,总会给被偷拍者带来严重的心理负担。仿佛真的被脱光了衣服一般,被众人观摩,指指点点。

每个人都有可能成为色情报复的受害者,即使没有拍过一张裸体照片,也可能会成为受害者。

AI脱衣的诞生,不会是人类科技的进步,反倒是人性的退步!